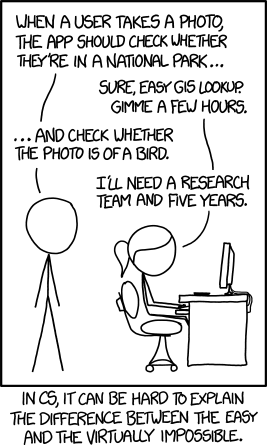

Порекомендую интересную статью про возможные грядущие ограничения в области обучения нейросетей. Я в своё время много с ними игрался; самым интересным проектом с моим участием был поиск потенциальных террористов в Фейсбуке с применением нейросетей. Модель, разумеется, делал уже не я, а просто немного перепилил гугловский Inception. При помощи нейросетей можно решать проблемы, которые очень сложно алгоритмизировать. Так, этот комикс xkcd уже не является такой уж проблемой.

В статье довольно подробно разбираются потенциальные затыки технологии. И самым большим затыком сейчас является ограничение по количеству параметров, которое сейчас быстро растёт. Если мы возьмём обычную полностью связанную нейросеть в 20 слоёв с 10 000 нейронами в каждом слое — чтобы эту сеть запустить, нам потребуется примерно 5.7E+66 терабайт оперативной памяти. Таких мощностей у нас нет и не предвидится, так что тупое наращивание параметров нейросети чтобы получить более интересные результаты — это путь однозначно тупиковый.

Поэтому делаются свёрточные сети, субдискретизации, подвыборки, и прочее шаманство, которым по-настоящему хорошо в мире владеет очень небольшое количество людей.

Автор, однако, довольно оптимистичен, и возлагает надежды на хардверные, в том числе и аналоговые вычисления.